El modo Pixel Shift se está convirtiendo en una de las novedades más relevantes de las cámaras de gama alta del 2017. La Sony A7 R III cuenta con el modo Pixel Shift, aunque no es la única. Otras cámaras como la Pentax K-1 (la nueva Pentax K-1 Mark II) o la Panasonic G9 cuentan con el mismo modo. Pero, ¿cómo consigue realmente el modo Pixel Shift de la Sony A7 R III fotos de más calidad?

Sony A7 R III con modo Pixel Shift

El modo Pixel Shift que incluye la Sony A7 R III es un modo con el que se consiguen fotografías de una calidad superior. Tanto los colores como el nivel de detalle de la imagen son superiores. Y es un modo de captura ideal para fotografía de paisaje, arquitectura, producto, o cualquier otra fotografía de un sujeto inerte y estático.

En realidad, la cámara realizará cuatro fotografías que combinará para obtener una imagen final de más calidad. Si bien es cierto que la captura de las cuatro imágenes es rápida, no lo suficiente como para capturar sujetos en movimiento. Olvidaos de deporte, animales, o incluso retratos que no sean de estudio. Hasta los de estudio serían complejos.

En cualquier caso, cada vez que se presenta una cámara nueva se afirma que es capaz de hacer muy buenas fotos. Pero en ocasiones, lo cierto es que las novedades de la cámara no son tan relevantes y al final es capaz de hacer fotos igual que una versión anterior de la cámara o que otra cámara parecida que no presenta el supuesto «innovador» modo de fotografía.

¿Ocurre eso con el modo Pixel Shift de la Sony A7 R III? ¿O es un modo realmente útil? Sí que lo es, y vamos a explicar por qué.

Cómo funciona un sensor de fotografía

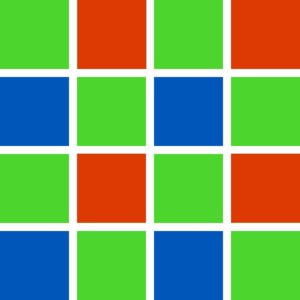

Los sensores de las cámaras de fotos cuentan con número de píxeles determinado. 16 megapíxeles, son 16 millones de píxeles. Cada píxel es un sensor de luz. Pero cada píxel capta un color diferente de los tres colores que componen la luz: rojo, verde y azul, que por sus siglas en inglés es R G B. Pero cuando nosotros vemos una fotografía y ampliamos el zoom hasta ver un único píxel, no vemos solo un píxel verde, azul o rojo… vemos un píxel de un color que no suele ser ninguno de los tres. ¿Por qué? Porque se combinan los tres colores.

Pero, ¿no hemos dicho que cada píxel solo capta luz en un color? Así es. La imagen que hay sobre el párrafo muestra cómo sería una zona del sensor. Cada uno de los píxeles es de un color.

En realidad, cada uno de los píxeles utiliza la información de los píxeles que hay al lado, de otros colores, para determinar cuál es el color real de ese píxel en concreto. Esto se denomina interpolación.

Supongamos que tenemos el píxel (A) en la imagen a continuación.

![]()

El píxel detecta el color verde. No obstante, la cámara determinará también valores azul y rojo para ese mismo píxel. ¿Cómo? Por medio de la interpolación.

![]()

Utiliza los píxeles rojos a su alrededor para determinar el nivel de rojo que habría en ese píxel. Y lo mismo ocurre con el azul:

![]()

La interpolación es un cálculo bastante preciso. Teniendo en cuenta la cantidad de píxeles que hay en un sensor, millones, se puede decir que las fotografías que se captan cuentan con un nivel de detalle de color bastante real.

Sin embargo, ¿puede ser mejor? Supongamos que existiera un píxel capaz de detectar los tres colores y decirnos los niveles de los tres de forma precisa y exacta. Por supuesto, habría más datos todavía sobre el color de la imagen, y sería parecido a conseguir una imagen con una resolución superior. Una cámara así no contaría exactamente con el triple de resolución que una cámara actual,porque la interpolación es bastante precisa. Pero sí se puede decir que la fotografía final contaría con una resolución superior.

No obstante, es imposible que un solo píxel sea capaz de medir el nivel de la luz en los tres colores. Pero para eso existe el modo Pixel Shift.

La utilidad del modo Pixel Shift

El modo Pixel Shift desplaza el sensor una distancia de un píxel, cuatro veces. De esta forma no es necesario calcular el nivel de color de un píxel interpolando los valores de los otros píxeles, sino que es posible llevar cada uno de los otros píxel al lugar del píxel original para capturar de nuevo la imagen. Son necesarias cuatro fotografías para conseguir captar todos los colores en todos los píxeles. La imagen a continuación es del modo Pixel Shift de Sony y lo ejemplifica a la perfección.

![]()

A la izquierda está el modo Pixel Shift, y a la derecha el modo de captura convencional. Hay muchos más datos sobre el color en la fotografía captada con Pixel Shift.

El inconveniente es que para capturar una fotografía con el modo Pixel Shift, la fotografía debe ser estática. No obstante, las cámaras que cuentan con el modo Pixel Shift, tales como la Sony A7 R III, la Pentax K-1 y la Panasonic G9, dan la opción de activarlo o de no activarlo, por lo que podemos utilizar la cámara perfectamente sin el modo Pixel Shift. De hecho, el modo Pixel Shift no es el estándar. Podemos activarlo, igual que el bracketing para el HDR. Es más, el Pixel Shift es un modo de bracketing. Pero en vez de modificar la exposición, o el enfoque, se desplaza el sensor. Para ello, las cámaras utilizan el sistema de estabilización óptica de imagen.

Estabilización de imagen

El sistema de estabilización óptica de imagen desplaza el sensor para corregir el movimiento de la cámara al captar una fotografía. Digamos que el sensor «flota» para quedarse estático incluso cuando movemos la cámara. El modo Pixel Shift es todo lo contrario. Mientras la cámara está estática, el sensor se desplaza para captar más datos del color. Y la Pentax K-1 tiene un modo que desplaza el sensor siguiendo las estrellas para poder capturar fotografía de estrellas con tiempos de exposición más largos sin que las estrellas aparezca como líneas de luz en la cámara, algo que suele ocurrir cuando utilizamos tiempos de exposición muy superiores a los 30 segundos con muchas variantes de ajustes en la cámara.